Benefits & Risks of Artificial Intelligence Japanese

Contents

人工知能の利点とリスク

Click here to see this page in other languages:![]() Chinese

Chinese ![]() French

French ![]() German

German![]() Korean

Korean ![]() Russian

Russian ![]()

AIとは?

人工知能(AI)は、SIRIから自動運転車に至るまで急速に進歩しています。サイエンス・フィクションの中では人間のような特性を持つロボットのように描かれていることが多いですが、AIは、Googleの検索アルゴリズム、IBMのワトソン、自律型ロボット兵器に至るまで、様々なものを包含することができます。

昨今知られている人工知能は、正確には狭義のAI(または弱いAI)であり、特定の作業(例えば、顔認識のみ、インターネット検索のみ、車の運転のみ)を行うように設計されています。しかし、多くの研究者の長期的な目標は、広義のAI(AGIもしくは強いAI)を作成することです。狭義のAIが、チェスをしたり方程式を解いたりと、何であれその特定の作業において人間を上回るのに対して、AGIは、ほぼすべての認知的作業において人間を上回るでしょう。

AIの安全について研究する理由は?

短期的には、AIの影響を社会に有益に保つという目標が、経済学や法律や、検証、妥当性、セキュリティ、制御などの技術的な話題に至るまで、多くの分野での研究を促進します。あなたのノートパソコンが故障したりハッキングされたら多少の不自由という以上の問題ではありますが、AIシステムが、あなたの車、飛行機、ペースメーカー、自動取引システム、電力網をコントロールするとしたら、そのシステムがあなたの思い通りに作動することはより一層重要になります。もう一つの短期的な課題は、自律型ロボット兵器による壊滅的な軍拡競争を防ぐことです。

長期的には、重要な問題は、強いAIの作成に成功しAIシステムがすべての認知的作業で人間を上回る場合に何が起こるかです。1965年にI.J.グッドが指摘したように、より知的なAIシステムを設計すること自体が認知的作業です。そのようなシステムは、自己改善を繰り返し、人間の知性をはるかに超えて爆発的な知的発達を遂げる可能性があります。革命的な新技術を発明することで、そのようなものすごい知性を使い、私たちは戦争、病気、貧困を撲滅できるかもしれず、そのため、強いAIの作成は人類の歴史の中で最大のイベントとなり得ます。しかし、一部の専門家は、AIがものすごく知的になる前に私たちとAIの目標を整合することを学ばない限り、AIが人類の終わりとなるかもしれないと懸念を表明しています。

強いAIが達成されるかどうか自体に疑問を呈す人もいれば、ものすごく知的なAIの作成は有益であることが保証されていると主張する人もいます。FLIはこれらの両方の可能性を認識するだけでなく、人工知能システムが意図的にもしくは意図せずに大きな害を引き起こす可能性をも認識しています。私たちは、今日の研究が、将来の悲惨な結果に備えること、それを防ぐこと、また危険を回避してAIの恩恵を受けることを助けることを信じています。

AIはどのように危険でありうるのか?

ほとんどの研究者が、ものすごく知的なAIが愛や憎しみのような人間の感情を示すことはおそらくなく、AIが意図的に善意や悪意を持つことを期待する理由はないと考えています。 その代わり、専門家たちは、AIがどのように危険でありうるのかを検討する際、次に示す2つのシナリオの可能性がもっとも高いと考えます。

- AIは壊滅的な何かを実行するようにプログラムされている:自律的ロボット兵器は殺傷を目的としてプログラムされた人工知能システムです。間違った人の手にかかれば、これらの兵器によって容易に大量の死傷者が発生しかねません。さらに、AIの軍拡競争は意図せずに大量の死傷者が生じるAIの戦争につながる可能性があります。敵による妨害を避けるため、これらの兵器は、簡単に「電源をオフにする」ことが極めて困難であるように設計されるでしょう。そのため、人間がそのような状況をコントロールできなくなる可能性が大いにあります。このリスクは狭義のAIにもつきまといますが、AIの知性と自律性が増加するほどにリスクは大きくなります。

- AIは有益な何かを実行するようにプログラムされているものの、その目標を達成するために破壊的な方法を発達させてしまう:これは私たちの目標がAIの目標と完全に整合しなかった場合に起こりえるシナリオで、防ぐことが大変困難です。もしあなたが従順で知的な自動運転車に可能な限り速く空港に着くように要求したとしたら、ヘリコプターに追われても嘔吐物に覆われても構わず、それがあなたの本当に望んだことでないにも関わらず、あなたの要求を文字通り認識し、空港に全速力で向かうかもしれません。もし、ものすごく知的なシステムは野心的な地球工学プロジェクトを任された場合は、副作用としてエコシステムの大混乱をもたらすかもしれず、それを止めるための人間の試みを脅威と見る可能性もあります。

これらの例が示すように、高度なAIに関する懸念は悪意ではなく能力の問題です。 ものすごく知的なAIは、その目標を達成するための能力は非常に高いものの、それらの目標が私たちの目標と整合していない場合、私たちにとって問題です。あなたはおそらく悪意を持ってアリを踏みつけるあくどいアリ嫌いではないでしょうが、もしも水力発電グリーンエネルギープロジェクトを担当していて、浸水すべき地域にアリ塚があったとしたら、そのアリのことは諦めるでしょう。AIの安全研究の主要な目標は、これらのアリの立場に決して人間を置かないようにすることです。

なぜ最近AIの安全への関心が高まっているのか

スティーヴン・ホーキング、イーロン・マスク、スティーブ・ウォズニアック、ビル・ゲイツをはじめとする多くの科学技術分野におけるビッグネームが、最近メディアもしくは公開状を介してAIによるリスクについての懸念を表明し、多くの大手のAI研究者も賛同しています。なぜこの課題が突然注目を浴びているのでしょうか?

強いAIのための探求が最終的に成功するだろうという考えは、サイエンス・フィクションのように何世紀以上も先のことと考えられていました。しかし、最近のブレークスルーのおかげで、専門家がたった5年前に数十年も先のことと考えた多くのAIのマイルストーンは現在達成されており、多くの専門家が私たちの世代が生きている間にものすごい知性が誕生する可能性を真剣に検討しています。一部の専門家は、まだ人間レベルのAIは何世紀も先のことと推測していますが、2015年プエルトリコ会議に参加したほとんどのAI専門家は、それが2060年より前に開発されるだろうと推測しています。必要な安全性研究を完了するのには数十年かかるかもしれないことを考慮すると、今研究を開始することが賢明です。

AIの知性はあらゆる人間を超える可能性があるため、私たちにはそれがどのように動作するかを予測する確実な方法がありません。私たちは、意図的にも無意識のうちにも私たちの裏をかく能力を持つ何かを作成したことがないため、過去の技術開発を基盤として使用することができません。私たちが直面する可能性が何であるかの最良の例は、私たち自身の進化かもしれません。人類は現在地球を支配していますが、それは私たちが最強、最速、最大だからではなく、最も賢いためです。もしも私たちが最も賢いわけではなくなれば、この支配は続かないかもしれません。

FLIのスタンスは、私たちが技術の成長力とそれを管理する知恵の競争に勝っている限り私たちの文明は栄える、というものです。AI技術に関するFLIのスタンスは、その競争に勝つための最善の方法が、前者を妨害するのではなく、AIの安全性の研究を支援することにより後者を加速することだ、というものです。

高度なAIについて最もよくある思い込み

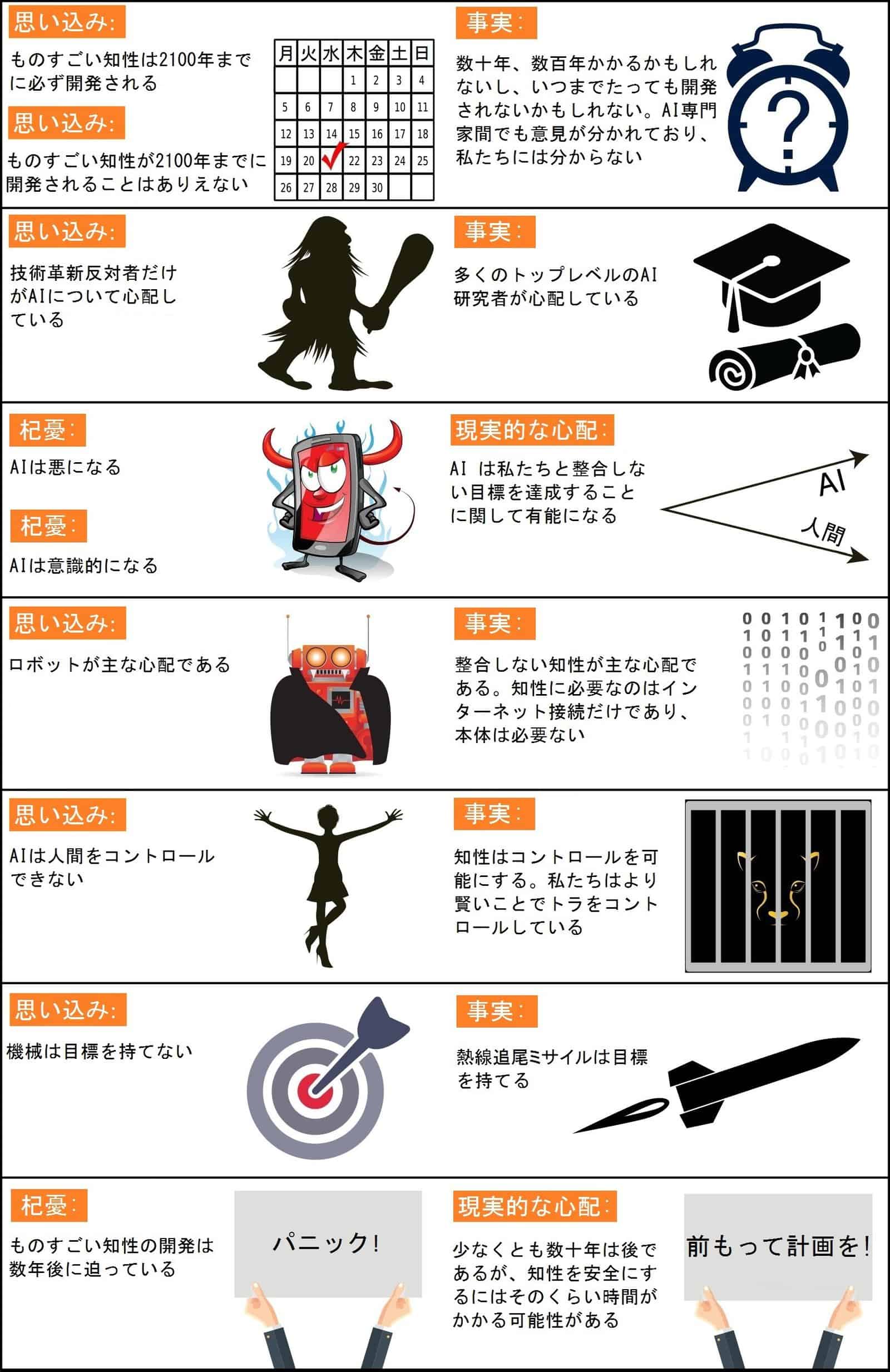

人工知能の将来やそれは人類にとって何を意味するのか、意味すべきなのか、について魅惑的な会話が交わされています。中には世界有数の専門家の間でも意見が分かれる魅力的な論争もあります。たとえば、雇用市場へのAIの将来の影響、人間レベルのAIが開発されるかどうか、もしそうならそれはいつか、それは爆発的な知的発達につながるかどうか、そして私たちはそれを歓迎すべきなのかそれとも恐れるべきなのか。しかし、誤解や会話のすれ違いによって生まれた退屈な擬似論争もあります。誤解ではなく、興味深い論争とオープンな質問に焦点を当てられるよう、最も一般的ないくつかの思い込みを解消しましょう。

タイムラインに関する思い込み

まずは、機械が人間の知性レベルを大幅に超えるまでどのくらい時間がかかるか?というタイムラインに関する思い込みが挙げられます。よくある誤解は、私たちがこの質問に正確に答えられるというものです。

よくある思い込みの一つは、私たちが今世紀中に超人的なAIを開発することを確信している、というものです。実際に過去には技術が頻繁に大げさに騒ぎ立てられてきています。現時点までには開発されていると信じられた核融合発電所や飛行する車は未だどこにも見当たりません。AIもまた、その分野の創設者によってさえ、過剰に宣伝されてきました。例えば、ジョン・マッカーシー(用語「人工知能」を造語)、マービン・ミンスキー、ナサニエル・ロチェスター、クロード・シャノンは、原始的なコンピュータが2ヶ月間でどこまで達成できるかについて、次のような過度に楽観的な見通しを書きました。「私たちは、ダートマス大学で1956年の夏に2ヶ月間10人がかりで人工知能の研究を行うことを提唱します(…)機械が言語を使用し、抽象化と概念を形成し、現在人間が直面する課題を解決する方法を見つけ、機械自身を向上させる方法を見つけることを試みます。私たちは、厳選された科学者のグループがひと夏一緒に作業をすれば、これらのうち一つまたはそれ以上の課題において著しい進歩を遂げられると考えます。」

一方、よくある逆の思い込みは、私たちは今世紀中に超人的なAIを開発できないことを確信している、というものです。研究者たちは超人的なAIがいつ開発されるかについて広い範囲の予測をしていますが、技術に懐疑的な予測のこれまでの惨憺たる実績を考慮すると、今世紀中の開発の可能性がゼロであることを確信することはできません。例えば、1933年には、間違いなく当時最大の核物理学者であったアーネスト・ラザフォードが、原子力エネルギーの開発を「たわごと」だと言いました。ところが、それから24時間も経たないうちに、シラードが核連鎖反応を発明しました。そして、王室天文官のリチャード・ウーリーは、1956年に惑星間旅行を「全くのたわごと」だと言いました。最も極端な思い込みは、超人的なAIは物理的に不可能であり決して開発されない、というものです。しかし、物理学者たちは、脳が強力なコンピュータとして動作するように配置されたクォークと電子で構成されており、私たちが脳より知的なクォークの塊を構築することを妨げる物理の法則は存在しないことを理解しています。

今から何年後に私たちが少なくとも50%の確率で人間レベルのAIが開発されると思うかをAI研究者に対して問う多くのアンケートが行われてきました。これらの調査は、全て同じ結論に辿り着きました。世界有数の専門家が同意しないため、私たちには見当がつかない、というものです。例えば、2015年プエルトリコAI会議におけるAI研究者に対する調査では、平均値(中央値)の答えは2045年でしたが、一部の研究者は数百年以上先の予測を示しました。

関連する思い込みとしては、AIについて心配する人々が、それがほんの数年先に開発されると考えていることが挙げられます。実際には、超人的なAIについて心配する記録に残るほとんどの人は、少なくとも数十年先までは開発されないと考えています。しかし、そういった人たちは、私たちがAIが今世紀中に起こることはないということを100%確信できない限り、不測の事態に備え安全性の研究を始めることが賢明だと主張しています。人間レベルのAIと関連する安全性の問題の多くは非常に難しく解決するのに数十年かかる可能性があります。そのため、数人のプログラマーがレッドブルを飲みながらスイッチを押す決定をする一晩前ではなく、今研究を開始することが賢明です。

議論に関する思い込み

他によくある誤解は、AIに関する懸念を持ちAIの安全性研究を提唱する人だけがAIについてよく知らない技術革新反対主義者だ、というものです。標準的なAIの教科書の著者であるスチュアート・ラッセルがプエルトリコのプレゼンテーションにてこれを述べたとき、観客から大きな笑いが起きました。関連した誤解は、AIの安全性研究への支援は非常に意見が分かれる対象だというものです。実際には、AIの安全性研究へのささやかな投資を支援するのに、リスクが高く単に無視できないということを確信している必要はありません。住宅保険への適度な投資が、家が火事に遭うという無視できない確率によって正当化されるのと同様です。

これには、メディアによってAIの安全性の議論が実際以上に物議を醸しているように見えていることが考えられます。結局、恐怖をあおることは利益につながるのです。文脈を無視した引用を使って差し迫った悪い運命を宣言する記事は微妙でバランスの取れた記事よりも好まれます。その結果、唯一のメディアの引用からそれぞれのポジションについて知っている二人は、彼らが実際以上に意見を違えていると思う可能性があります。たとえば、英国のタブロイド紙でビル・ゲイツのスタンスについて読んだだけの技術懐疑者が、ゲイツがものすごい知性が切迫であることを信じていると思い込むかもしれません。同様に、アンドリュー・ングのスタンスについて火星の人口過剰についての引用以外に何も知らないAIの有益性支持者が、彼がAIの安全性を気にしないと思い込むかもしれませんが、実際には間違っています。核心は、単にングのタイムラインの推定値が長いため、彼は自然に短期的なAIの問題を長期的な問題よりも優先させる傾向があるというだけなのです。

超人的なAIのリスクに関する思い込み

「スティーブン・ホーキングは、ロボットの発展は人類にとって悲惨なことかもしれないと警告しています。」という見出しを見て、多くのAI研究者はあきれます。そして数え切れない似た様な記事を見てきています。一般的にこういった記事は、武器を持った意地の悪そうなロボットの写真を伴っており、そのロボットが立ち上がり、意識的かつもしくは悪となり、私たちを殺す心配があると示唆します。もっと軽く表現するならば、このような記事は、簡潔にAI研究者が心配しないシナリオを見事にまとめています。そのシナリオは、意識に対する懸念、悪に対する懸念、ロボットに対する懸念、という最大3つの別々の誤解を含んでいます。

人間が運転する際には、音や色に対する主観的な経験をします。しかし、自動運転車は主観的な経験をするでしょうか?自動運転車何かを感じることがあるのでしょうか?こういった意識に関する謎は、それ自体興味深くはありますが、AIのリスクとは無関係です。あなたが無人車に轢かれた場合、車は主観的に意識を感じているかどうかは問題ではありません。同様に、私たち人間に影響があるのは、ものすごく知的なAIが何をするかであり、何を主観的に感じるかではないのです。

機械が悪に転じるという恐れというのは、また別の目くらましです。本当に心配すべきは悪意ではなく、能力です。ものすごく知的なAIは当然ながら、目標が何であれ、その目標を達成ことには非常に優れているので、私たちはその目標が私たちの目標と揃っていることを確認する必要があります。人間は一般的にアリをそこまで嫌うことはないですが、私たちはアリよりも知的です。そのため、もしも私たちが水力発電ダムを建設したいとして、その地域にアリ塚があったとしたら、そのアリのことは諦めるでしょう。有益なAIを推進する人々は、これらのアリの立ち位置に人間を置かないようにしたいと考えています。

意識に関する誤解は、機械が目標を持つことができないという思い込みに関連しています。機械は、明らかに目標指向の挙動を示すという狭い意味で目標を持つことができます。熱線追尾ミサイルの挙動が最も効率的にターゲットを攻撃できることがそれを説明しています。もしあなたがあなたと合わない目標を持っている機械によって脅威を感じるとしたら、機械に意識や目的意識があるかどうかが問題なのではなく、機械が持つ狭い意味での目標自体が問題なのです。もしあなたが熱線追尾ミサイルに追いかけられたら、「機械は目標を持つことができないので、私は心配する必要はない!」と叫ぶことはおそらくないでしょう。

執拗にロボットに固執し、赤く光る目で意地の悪そうな金属モンスターの写真で多くの記事を飾るジャーナリストが存在する中、私はデマを飛ばす大衆紙によって悪者扱いされるロドニー・ブルックスと他のロボット工学のパイオニアに同情します。実際には、有益なAIを推進する人々の主な関心は、ロボットではなく、知性自体なのです。具体的には、知性の目標は私たちのそれと合っていないことです。私たちに問題を引き起こすために、このようなかち合わない超人的な知性にはロボット本体は必要ありません。単にインターネット接続があればよいのです。それだけで知性は金融市場を乗っ取り、人間の研究者を超える開発を遂げ、人間の指導者を超えて人々を操作し、私たちの理解を超える兵器を開発するかもしれません。ロボットの構築が物理的に不可能であったとしても、ものすごく知的でお金持ちのAIは簡単に支払を済ませるか多くの人間を操作して無意識のうちに入札を行わせることができるでしょう。

ロボットに関する誤解は、機械が人間を制御することはできないという思い込みに関連しています。知性はコントロールを可能にします。人間は虎を制御していますが、それは私たちの方が強いからではなく、より賢いためです。これは、私たちが地球上で最も賢い立場でなくなった場合、私たちは制御する立場でもなくなる可能性があることを意味しています。

興味深い議論

上記の誤解に時間を費やして無駄にしなければ、私たちも専門家間で意見が分かれる本当に興味深い議論に集中することができます。あなたはどのような将来を実現したいですか?致死的な自律兵器は開発されるべきでしょうか?業務の自動化がどのように発展したらよいと思いますか?子供たちにはどのようなキャリアアドバイスを与えますか?古いものを置き換える新たな雇用と、誰もが余暇や機械によって生産された富を得て職のない生活を楽しむ社会のどちらが好ましいですか?将来は、ものすごく知的な生活を作成し、それを宇宙にまで広めたいですか?私たちは知的なマシンをコントロールするのでしょうか、それとも私たちがコントロールされてしまうのでしょうか?知的な機械は、私たちを置き換えるのでしょうか、私たちと共存するのでしょうか、それとも私たちと融合するのでしょうか?人工知能の時代が到来した際には人間であるということは何を意味するのでしょうか?どんな意味であってほしいですか、そして私たちはどうしたらその未来を実現できるでしょうか?この議論に参加してください!

About the Future of Life Institute

The Future of Life Institute (FLI) is a global think tank with a team of 20+ full-time staff operating across the US and Europe. FLI has been working to steer the development of transformative technologies towards benefitting life and away from extreme large-scale risks since its founding in 2014. Find out more about our mission or explore our work.